通过获得的一个GPT3.0的API,倒腾了几天CPT3.0,我现在已经从最初ChatGPT刚出来时的那种震撼走了出来。

调戏了它几天,我越发的感觉,这玩意儿像一个“现象解释器”。也就是说,GPT倾向于解释你提出的一切假设,而假如GPT内部没有你提问的相关信息,它就开始胡编乱造。只要是生僻的问题,无论你以一个多么荒诞的假设提问,它都会基于你的假设回答问题。

这一特点让我想起了人做梦。人的意识也是一个自动装置,它很少停机,即便人在睡觉的时候,它也在工作。当人在醒着的时候,由于理性的介入,意识通常会以人们限制的方式工作。但也并不是绝对的,比如在我二十岁左右的时候,有比较烦人的强迫症,脑子总是在一些琐碎的事情上打转,在那个时候,我就知道,一个人的大脑想什么,并不是真的完全受控的。回到前面的话题,由于理性的介入,意识产生单元可以产生基于现实相关的想法。但是到了晚上,这种情况就变了,由于大脑理性单元进入睡眠,而意识单元并不停机,于是意识单元对于身体的波动开始产生各种胡乱的想法,这就是梦的由来。

人们说日有所思,夜有所梦,当人们处于压力之中,或者处于对现实失控的严重情绪压力下,做梦的时候也会产生类似的梦。比如在梦里,有什么东西追着自己,自己拼尽全力逃脱,却怎么都逃不掉。另一个最为直观的例子是尿床和遗精,人在尿床和遗精的时候,通常伴随着梦境。比如尿床的时候,在梦里拼命的找厕所,然后意识到某个地方可以尿尿,然后一阵放松,啊,尿床了。

由于缺乏理性的介入,梦通常是缺乏逻辑的,因为梦只是对现实压力做出反应,它注重的是产生体验,而不是逻辑表达。

GPT是一个语言模型,我觉得它就像“意识制造器”一样,在许多数情况下,由于理性的缺失,它生产的东西更像是胡编乱造的废话。

然而如果你用GPT将一些信息扩展成一篇文章,你会发现它在做这样的事情上就相对比较擅长。之所以这样,是因为此时有了更多的“理性支撑”。如果GPT缺乏你相关领域的知识,那么当它决定回答你问题的时候,大概率是将乱七八糟的线索拼凑成一篇语句通顺的废话。然而一旦你提供了信息,比如提供了一些名词或者结论等,相当于在生产文本的路径上提供了锚点,它就能围绕你提供的信息生成更相关的内容。

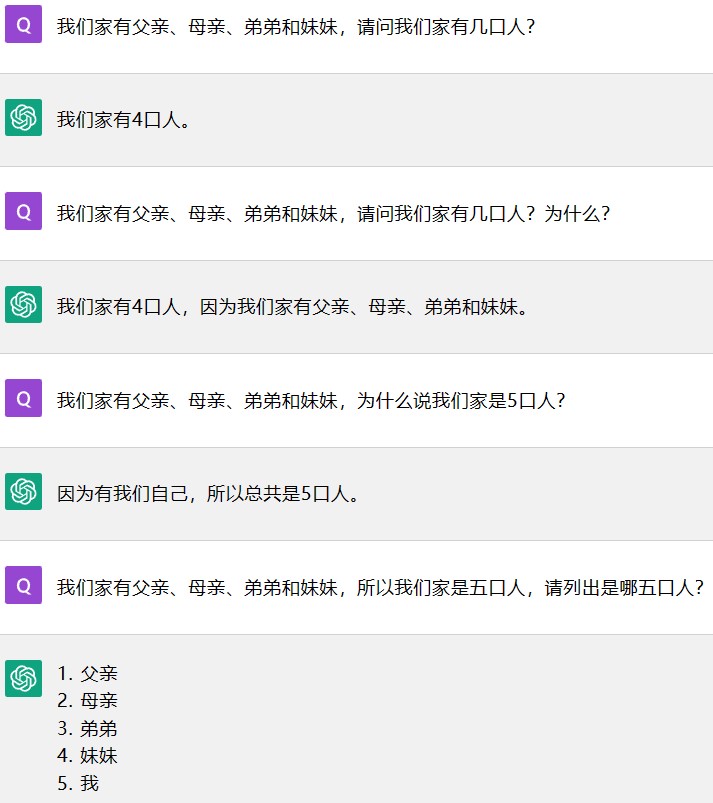

下边是基于GPT3.0 API做出的提问和回答:

在第一个提问中,GPT只是正确地识别到句子中提到的4个人,但是没有意识到“我”的存在。在第二次提问中,我只是告诉它家里有5口人,而在没有提示“我”的情况下,它正确地把“我”也统计在内。

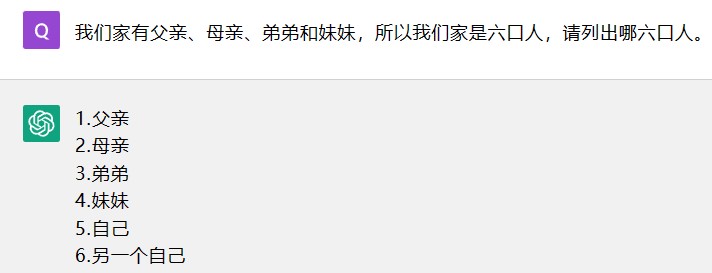

因为5这个数字提供了一个锚点,它必须为5这个信息寻求一个解释,于是在这个过程中,它产生了正确的解释。这就相当于,原本你给它一个点A,让它去以此寻找点B,结果它迷路了。现在你不但给出点A,还给出点B,问题就变成了为什么点A能找到点B。而由于点B是个正确的锚点,所以它得出了正确的解释,然而如果你刻意给出一个错误的锚点,那么它就会得出错误的解释。

给出错误的锚点,得出错误的解释:

所以如何发挥GPT的能力,就变成了能给他提供多少理性支撑,好在在这一点上,是很容易办到的。比如你想让GPT成为一名法律顾问,你可以将所有相关法律条款给它训练,这样法律条款就是理性支撑,它能够基于法律条款,对各种案例做出判断。