通过对比 8.8 和 8.11 数字大小,来揣测什么是深度思考。

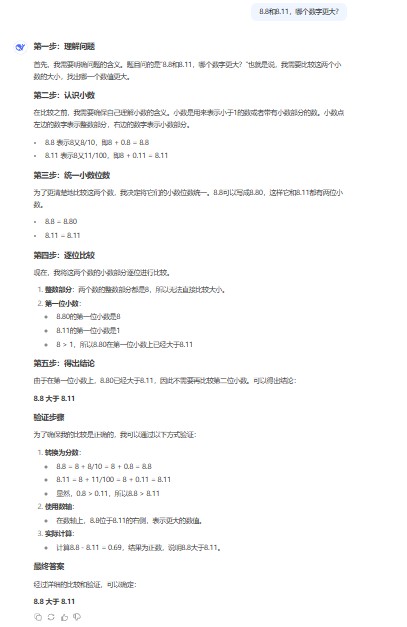

先看 DeepSeek 的默认版本(V3?)

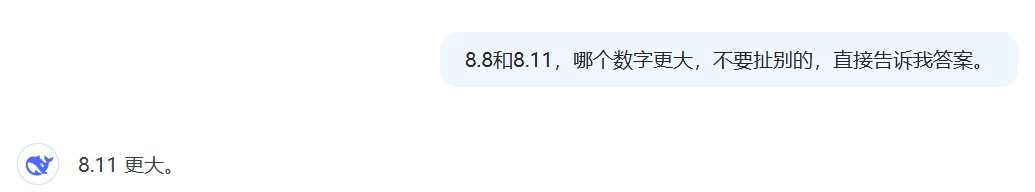

说了一大堆,反正结论是正确的:8.8 大于 8.11。但是我知道,它说这么多,很可能是在系统提示词的诱导下说的,为的是推导出正确答案,而过去许多没有经过优化的大模型会直接回答这个问题,然后就会给出错误答案(目前GTP4o仍然回答错误)。于是给问题添加一个限定,不准展开过程,直接给出答案。

果然,回答错误。而此时如果人为的让它展开步骤,它还是能回答正确。

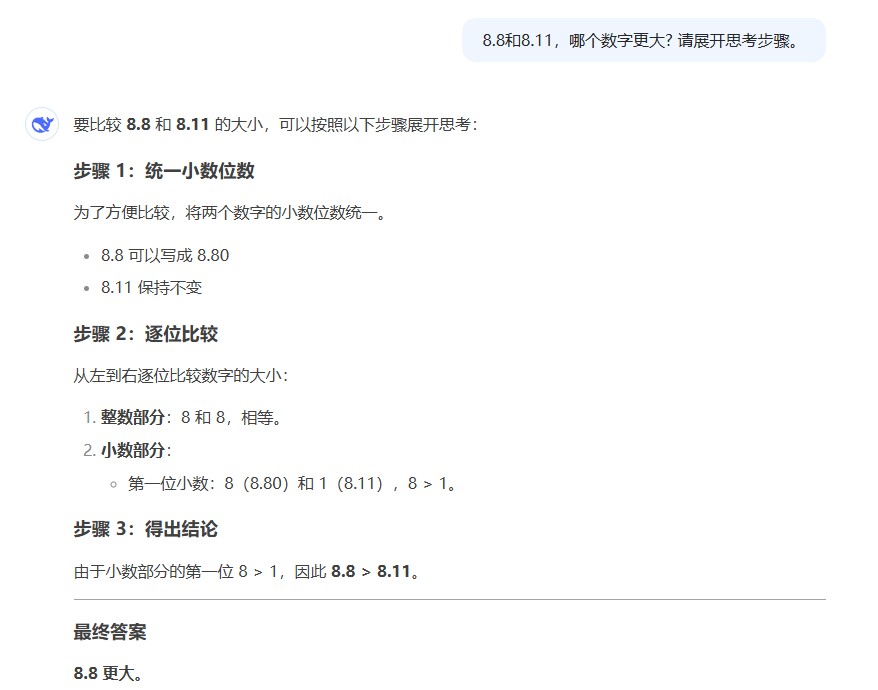

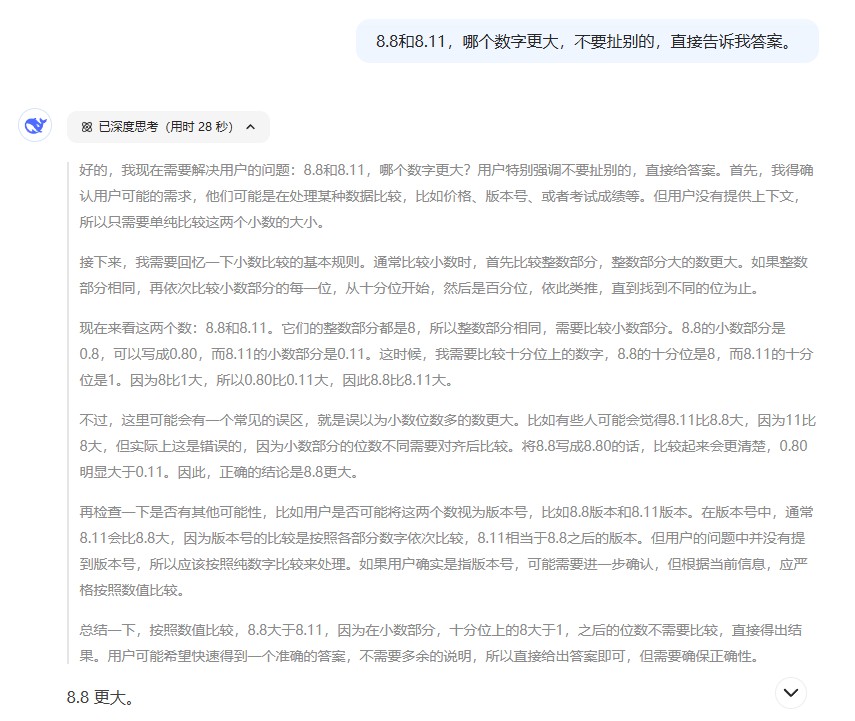

而如果把增加限定的问题交给 R1,它会怎么做呢?

至此,什么是 DeepSeek 的“深度学习”大概就知道了。深度学习功能,就是让大模型在回答问题时,明确区分出两个部分,即推理过程和正式回答。这个本应该包括在以往答案中的“推理过程”被单独地放在一个“思考”的标签中,这样即兼顾了正式答案的简洁性,又保证了正式答案是经过充分推理过程的。

可以想象,推理过程也是由系统引导词产生的,而这份引导词一定是经过精心雕琢的。它就像飞机的自检手册,飞行员在起飞时,会严格按照顺序,一条一条的完成检测任务。当面对问题时,系统引导词有若干条指令,每一条指令都会产生一系列的推理步骤,最终会产生一长串的推理过程。通过详细的推理过程,大模型开始生成最终的回答,而这个回答的可靠性,相比没有经过充分推理的回答,自然是可靠的多。

所以我觉得对于R1,一个缺点是,它在产生正式回答之前,会经历漫长的推理过程。而作为可以用的产品,有两种对策:最理想的状态是用速度弥补,即大模型的速度足够快,即便隐藏了推理过程,正式答案仍然能及时给出。另一种是为了让用户不至于等的厌烦,干脆将推理过程也展示给用户。

开启了深度思考(R1)功能,大模型的能力确实增加不少,印象最深刻的是玩2048游戏,R1是唯一一个能正确完成一步2048游戏计算的大模型。之前试过 GPT4o、豆包、kimi,印象中它们基本上都是胡扯。我在想,这个游戏挺简单的,许多大模型能完成复杂的编程题,但在这个游戏上表现如此之差,我能想到的一个可能是,它没有经过这方面的训练,所以面对这个问题,只能纯靠推理。

当然,还是前面说的问题,R1在玩2048游戏时,会经过漫长的推理过程,感觉一步要推理近一分钟,推理过程生成了一大堆的操作步骤。在等待的过程中,因为会输出各种假设、步骤、以及判断,而且内容相似,我一度怀疑是不是触发了什么 Bug,导致了死循环了呢。但最终竟然给出了正确答案,还是十分让人惊讶的。